探究青年学者使用大型语言模型完成学术任务的实证研究:文献回顾与论文理解

论文总结

摘要

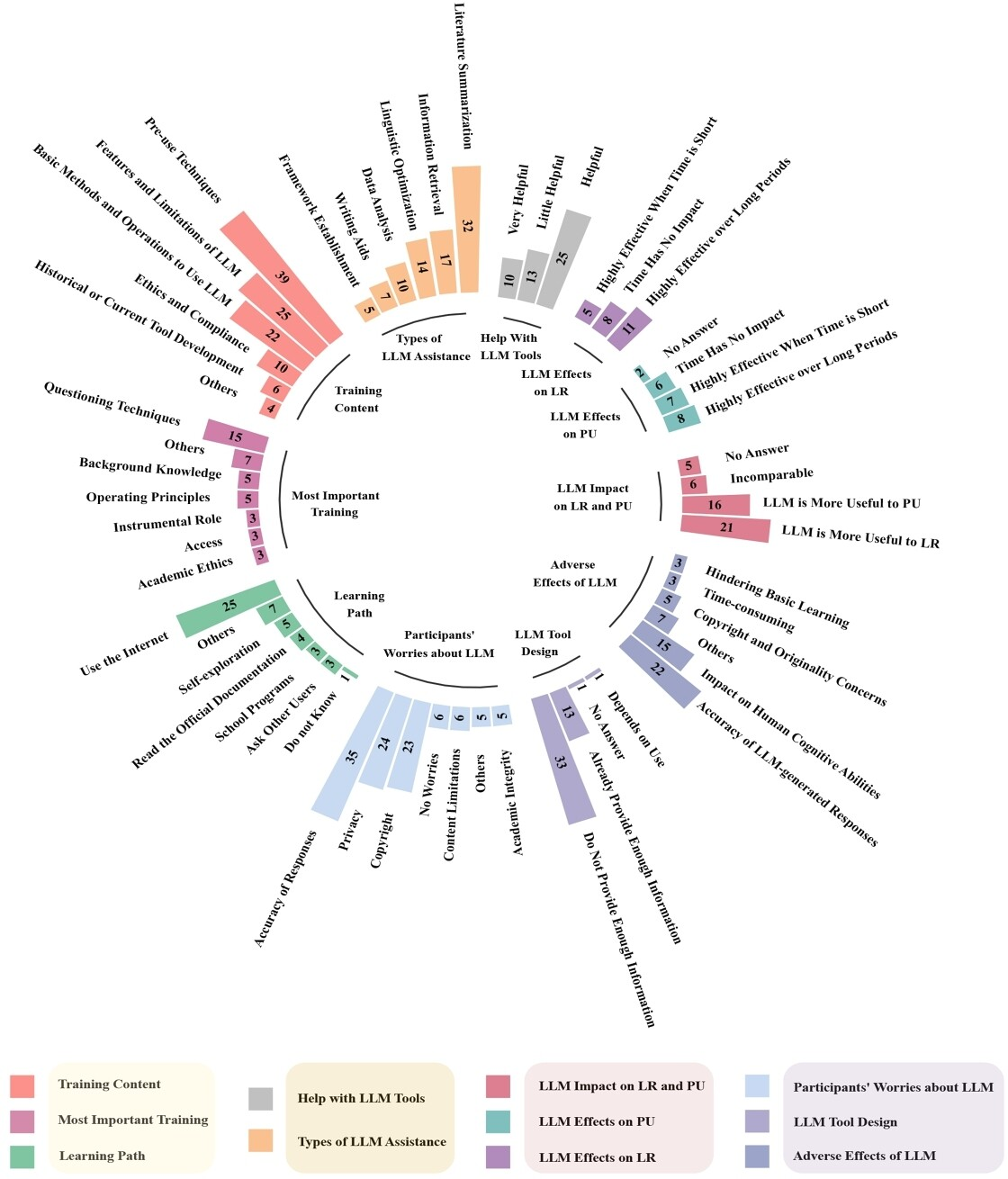

本研究通过实证调查和深度访谈,探讨了年轻学者在使用大型语言模型(LLMs)完成学术任务时的性能差异、策略选择以及对LLMs的看法。研究发现,在理解与综述文献方面,LLMs的作用被高度评价,但时间压力和任务类型会影响学者对LLMs的依赖程度。此外,作者还发现,获取适当的LLMs使用培训和设计具有透明度的工具可以提高用户满意度并促进有效的协作。

问题发现

- 性能差异:年轻学者在论文理解(PU)和文献回顾(LR)任务上的表现存在显著差异,尤其是在时间压力下。

- 策略选择:对于不同任务,用户对LLMs的依赖程度、使用方式及调整策略有所区别,例如,在时间压力较高的情况下,部分参与者可能优先完成任务而非关注LLMs的准确性。

- 态度与认知:受访者对LLMs的功能和局限性了解有限,且版权意识不足,特别是未发表过学术作品的研究新手。

- 培训需求:大部分学者希望在使用LLMs前接受指导,但官方提供的学习资源并不总是首选。

解决方案

- 透明度与教育:LLMs的交互界面和反馈机制需要改进,以提供更明确的指导和信息,帮助用户了解模型性能和可能的问题。

- 定制化工具:根据任务需求设计个性化的LLMs功能,如在文献理解任务中加强搜索和翻译功能,在文献回顾时鼓励深度阅读与批判性思考。

- 培训与教育:提供更易获取且有针对性的LLMs使用培训,包括对模型局限性和潜在风险的认识。

结果

- 性能影响因素:时间压力、任务类型以及用户对LLMs的理解会影响任务完成时间和质量。

- 策略调整:参与者在不同任务中灵活运用提问技巧、内容验证和适时利用LLMs以优化成果。

- 态度与行为:虽然多数学者对LLMs持积极态度,但实际使用时更倾向于依赖自己的能力,尤其在面临时间压力时。

总结来说,本研究揭示了年轻学者在使用LLMs时的性能差异和策略选择,并提出了提高用户满意度和任务效率的建议。未来设计和优化LLMs工具时,应考虑这些因素以适应不同学术任务的需求。

举一反三

Q1:如何提高年轻学者对大型语言模型(LLM)在学术任务中的有效使用?

A1:通过提供更具体和深入的培训,让学者了解LLM的功能、限制以及如何优化其生成的内容。同时,设计用户友好的界面和附带解释性注释可以增强用户体验。

Q2:时间压力对学者使用LLM的态度和策略有何影响?

A2:时间压力可能会影响学者对LLM的态度,他们可能会在紧迫的任务中更依赖这些工具以提高效率,但在低压力环境下,他们可能更倾向于自己完成任务以保证质量。

Q3:如何解决年轻学者在使用LLM时忽视其局限性的问题?

A3:通过提供正式的培训课程和教育资源,强调LLM的局限性和正确使用的注意事项。同时,设计工具时增加透明度,比如显示模型的信心分数或解释生成内容的原因,以帮助用户更好地理解和限制其使用。

内容由MiX Copilot基于大语言模型生成,有可能存在错误的风险。